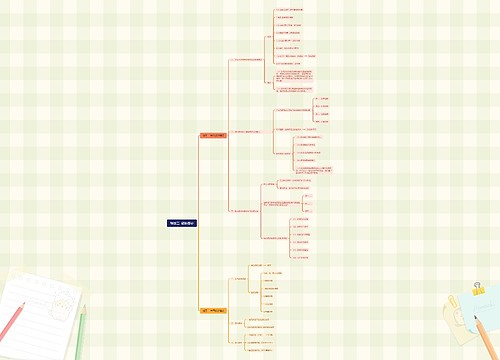

新产品数据收集流程思维导图

U274824267

2024-08-16

新产品数据收集流程内容简述

树图思维导图提供《新产品数据收集流程》在线思维导图免费制作,点击“编辑”按钮,可对《新产品数据收集流程》进行在线思维导图编辑,本思维导图属于思维导图模板主题,文件编号是:22c84bee2894f721f3f50b379c52d442

思维导图大纲

相关思维导图模版

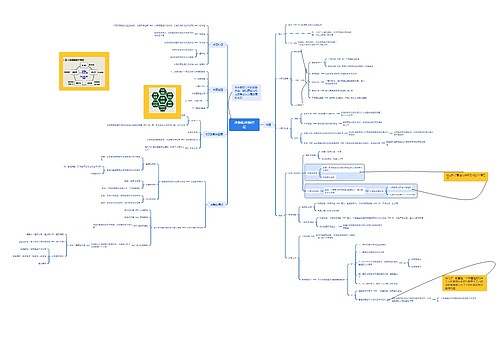

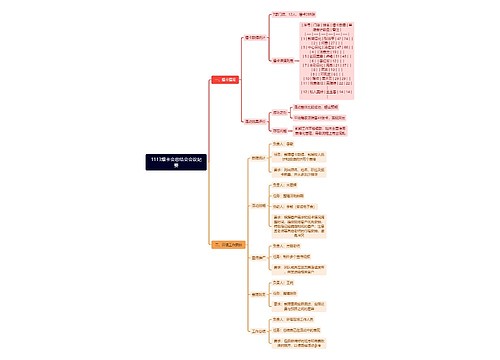

1113爆卡会总结会会议纪要思维导图

U245265618

U245265618树图思维导图提供《1113爆卡会总结会会议纪要》在线思维导图免费制作,点击“编辑”按钮,可对《1113爆卡会总结会会议纪要》进行在线思维导图编辑,本思维导图属于思维导图模板主题,文件编号是:aaf6c152a765d5821e8e1787f2b3226e

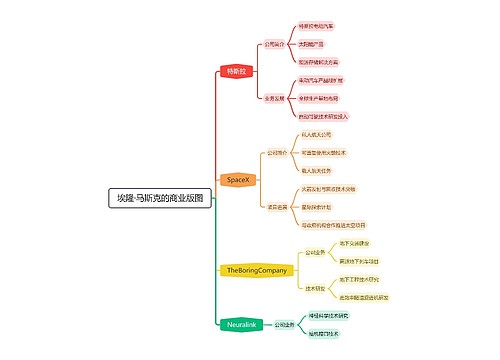

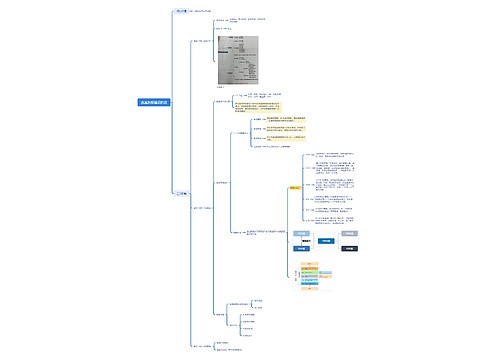

埃隆·马斯克的商业版图思维导图

乐农

乐农树图思维导图提供《埃隆·马斯克的商业版图》在线思维导图免费制作,点击“编辑”按钮,可对《埃隆·马斯克的商业版图》进行在线思维导图编辑,本思维导图属于思维导图模板主题,文件编号是:7464362ac911e8a334867bb3fc7a2346